La indexación es un aspecto fundamental en el SEO. Permite a los motores de búsqueda rastrear y clasificar el contenido de las páginas web, lo que influye directamente en la visibilidad y el tráfico orgánico de un sitio.

Este artículo detalla las mejores prácticas para optimizar la indexación. Se abordarán aspectos como la estructura de URLs, la creación de sitemaps, el uso de archivos robots.txt y otros elementos cruciales para mejorar el rendimiento en los resultados de búsqueda.

Importancia de la indexación en la estrategia SEO

La indexación es un factor esencial dentro de cualquier estrategia de optimización para motores de búsqueda, ya que permite a las páginas web ser encontradas por los usuarios. Un sitio web bien indexado tiene mayores posibilidades de ser presentado en los resultados de búsqueda relevantes.

Qué significa estar bien indexado

Estar bien indexado implica que las páginas de un sitio web han sido rastreadas y catalogadas adecuadamente por los motores de búsqueda. Este proceso asegura que el contenido esté fácilmente accesible y pueda ser presentado a los usuarios durante las búsquedas. Un sitio que no está bien indexado puede tener páginas que, aunque sean relevantes, no aparecerán nunca en los resultados.

- Rastreo eficiente: Los motores de búsqueda envían crawlers para explorar el sitio y encontrar contenido nuevo o actualizado.

- Indexación completa: Cada página debe ser almacenada en el índice del motor de búsqueda, lo que permite que sea recuperada fácilmente cuando un usuario realiza una búsqueda relacionada.

- Relevancia: Las páginas que se encuentran bien indexadas son más propensas a ser mostradas en los resultados de búsqueda, gracias a su contenido relevante y optimizado.

Impacto de la indexación en el tráfico orgánico

La indexación tiene un impacto directo en el tráfico orgánico de un sitio web. Mientras mejor esté indexado un sitio, mayores serán las posibilidades de recibir visitas desde los motores de búsqueda. Esto se traduce en más oportunidades para atraer usuarios interesados en los productos o servicios que se ofrecen.

- Visibilidad aumentada: Un buen nivel de indexación permite que las páginas sean visibles para el público objetivo. Sin una correcta indexación, el contenido puede permanecer oculto de los usuarios.

- Aumento del CTR: Sitios bien indexados suelen experimentar un aumento en la tasa de clics (CTR) debido a que aparecen en posiciones más altas en los resultados de búsqueda.

- Mejor conversión: Con un tráfico orgánico más alto, hay una mayor probabilidad de conversión, ya que se atraen usuarios activos que buscan información específica.

La combinación de una adecuada indexación y contenido de alta calidad contribuye a la eficacia de una estrategia SEO. Esto no solo mejora la posición en las páginas de resultados, sino que también proporciona valor tanto a los usuarios como al propietario del sitio web.

Cómo funciona el proceso de indexación

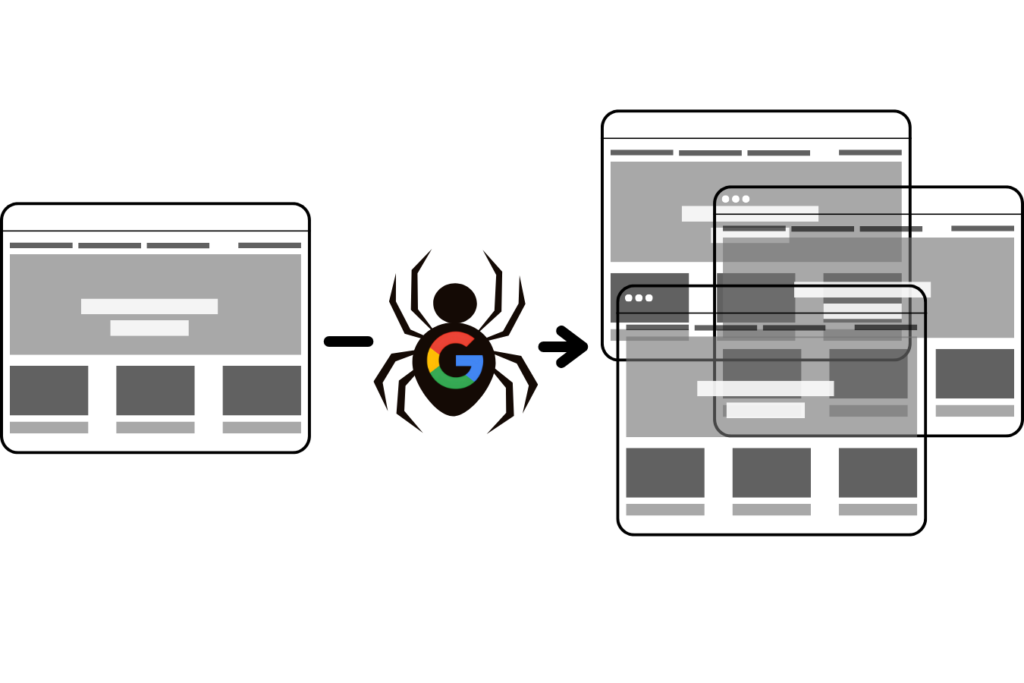

El proceso de indexación es fundamental para que la información disponible en la web sea accesible para los motores de búsqueda. A continuación se detalla cada etapa de este proceso, desde el rastreo inicial hasta la recuperación de resultados relevantes.

Rastreo y recopilación de datos

El rastreo es el primer paso que utilizan los motores de búsqueda para explorar la vasta cantidad de información disponible en la web. Los motores envían robots conocidos como crawlers o arañas, que visitan las distintas páginas siguiendo enlaces y recopilando datos sobre el contenido. Este proceso incluye varios aspectos importantes:

- Descubrimiento de nuevas páginas: Los crawlers utilizan enlaces internos y externos para encontrar nuevas URLs. Esto significa que al enlazar desde una página existente a una nueva, se ayuda a los motores de búsqueda a descubrir ese contenido.

- Actualización de contenido existente: Además de buscar nuevas páginas, los crawlers revisan las páginas ya indexadas en busca de actualizaciones y modificaciones. Esto es esencial para que los motores tengan información actualizada y relevante.

Almacenamiento y organización de la información

Una vez que el crawler ha visitado una página y tenido acceso a su contenido, se inicia el proceso de almacenamiento. En esta fase, ocurre lo siguiente:

- Recopilación de datos: Los crawlers recogen diversos elementos, como texto, imágenes y metadatos, que son esenciales para entender de qué trata la página.

- Indexación de contenido: Esta información se almacena en un índice, que es como una biblioteca donde se catalogan todas las páginas web por su contenido y relevancia. La forma en que se organiza el índice influye en los resultados de búsqueda futuros.

El índice no es público ni accesible para los usuarios, pero es fundamental para la rapidez y eficacia con que un motor de búsqueda puede proporcionar resultados relevantes a las consultas realizadas.

Recuperación de resultados de búsqueda

Cuando un usuario introduce una consulta en un motor de búsqueda, el sistema no realiza una búsqueda en línea en tiempo real. En su lugar, consulta el índice previamente creado. Durante este proceso, se tienen en cuenta varios factores:

- Relevancia: El motor de búsqueda evalúa qué páginas en su índice son más relevantes para la consulta del usuario. Esto incluye el contenido de la página, la calidad de los enlaces entrantes y otros factores de SEO.

- Clasificación: Las páginas que cumplen mejor con los criterios de búsqueda son clasificadas en las posiciones más altas de los resultados de búsqueda. Este ranking es crucial para que una página reciba tráfico orgánico.

- Presentación de resultados: Finalmente, el motor de búsqueda presenta los resultados al usuario, proporcionando descripciones adecuadas que inviten a los usuarios a hacer clic y visitar las páginas indexadas.

Este proceso continuo de rastreo, almacenamiento y recuperación es lo que permite a los usuarios acceder a información relevante y actualizada en la web. La comprensión de estos mecanismos puede ayudar a optimizar los sitios para mejorar su visibilidad en los motores de búsqueda.

Mejores prácticas para optimizar la indexación

Optimizar la indexación es esencial para que los motores de búsqueda puedan rastrear y entender eficientemente el contenido de un sitio web. A continuación, se presentan prácticas efectivas que pueden potenciar la visibilidad de las páginas en los resultados de búsqueda.

Uso de una estructura lógica de URLs

Las URLs son una parte fundamental para la indexación efectiva de una página web. Una estructura lógica no solo mejora la experiencia del usuario, sino que también facilita el trabajo de los motores de búsqueda.

Incluir palabras clave relevantes

Incluir palabras clave en las URLs puede ayudar a que los motores de búsqueda comprendan mejor el contenido de la página. Esto puede aumentar la relevancia de la URL para las consultas de búsqueda relacionadas. Las URLs que contienen términos de búsqueda son más propensas a recibir clics.

Crear URLs descriptivas

Las URLs descriptivas que reflejan el contenido de la página son más atractivas tanto para los usuarios como para los motores de búsqueda. Una URL clara y concisa facilita la identificación del tema de la página, mejorando la tasa de clics y la indexación.

Creación y mantenimiento de un sitemap XML

Un sitemap XML es una herramienta valiosa para facilitar el rastreo por parte de los motores de búsqueda. Proporciona una lista de las páginas de un sitio web y sus relaciones, lo que ayuda a los crawlers a navegar eficazmente.

Estructura de enlaces internos en el SiteMap

Asegurarse de que el sitemap refleje correctamente la estructura de enlaces internos del sitio es fundamental. Los motores de búsqueda pueden acceder más fácilmente a las páginas cuando están bien organizadas dentro del sitemap, lo que mejora la indexación general del sitio.

Implementación del archivo robots.txt

El archivo robots.txt es crucial para dirigir a los motores de búsqueda sobre qué áreas de un sitio deben ser rastreadas y cuáles deben ser ignoradas.

Bloquear páginas no relevantes

Es importante bloquear el acceso a páginas que no aportan valor significativo, como formularios o páginas de inicio de sesión. Esto permite que los recursos de rastreo se utilicen en páginas más relevantes y valiosas para el SEO.

Evitar contenido duplicado

El contenido duplicado puede confundir a los motores de búsqueda y diluir el valor del sitio. Utilizar el archivo robots.txt para bloquear estas páginas asegura que solo se indexe el contenido original y relevante, mejorando así la autoridad del dominio.

Optimización de la navegación interna

Una navegación interna bien diseñada no sólo mejora la experiencia del usuario, sino que también guía a los motores de búsqueda a través del contenido de un sitio web.

Accesibilidad de las páginas importantes

Todas las páginas que son críticas para la estrategia SEO deben ser fácilmente accesibles mediante enlaces internos. Esto asegura que tanto los usuarios como los motores de búsqueda puedan encontrar y rastrear información relevante sin dificultades.

Texto descriptivo en enlaces internos

Utilizar texto descriptivo en los enlaces internos proporciona contexto tanto a los usuarios como a los motores de búsqueda. Esto mejora la comprensión del contenido relacionado, lo que puede potenciar la indexación de esas páginas.

Técnica avanzada de indexación

La técnica avanzada de indexación se refiere a métodos y herramientas que permiten optimizar el proceso de indexación en motores de búsqueda. Incluye el uso de herramientas de análisis y la implementación de prácticas que mejoran la visibilidad del contenido en línea.

Monitorización de la indexación con Google Search Console

Google Search Console es una plataforma esencial para cualquier webmaster que desee monitorear y mejorar la indexación de su sitio web. Ofrece diversas funciones que permiten a los usuarios identificar problemas de indexación, optimizar rendimiento y garantizar que el contenido es accesible para los crawlers de Google.

- Supervisión de las páginas indexadas: Permite verificar cuáles páginas han sido indexadas y cuáles no. Esto es fundamental para identificar cualquier inconveniente que pueda estar impidiendo la correcta indexación de contenido relevante.

- Informe de cobertura: Proporciona detalles sobre errores de rastreo, como páginas no encontradas (404) o problemas de acceso. Resolver estos errores es crucial para mantener una buena salud del sitio en términos de SEO.

- Solicitud de indexación: Se puede solicitar manualmente la indexación de nuevas páginas o cambios en contenido ya existente. Esta función es útil especialmente tras actualizaciones o lanzamientos de nuevos productos y servicios.

Optimización para dispositivos móviles

La optimización móvil es un aspecto indispensable, ya que Google ha adoptado la indexación móvil primero. Esto implica que la versión móvil del sitio es la que se considera a la hora de evaluar y clasificar el contenido.

- Diseño responsive: Es esencial que el sitio sea accesible y fácil de navegar en dispositivos móviles. Un diseño adaptable mejora la experiencia del usuario y facilita el rastreo.

- Velocidad de carga: La rapidez de un sitio en dispositivos móviles es crucial. Herramientas como Google PageSpeed Insights pueden ayudar a evaluar y mejorar el tiempo de carga, lo que repercute positivamente en la indexación.

- Pruebas de usabilidad: Realizar pruebas periódicas en diferentes dispositivos móviles asegura que todas las funciones del sitio están operativas y accesibles. Esto contribuye a una mejor experiencia en general.

Gestión de redirecciones 301

Las redirecciones 301 son fundamentales para mantener la continuidad del tráfico y la autoridad del dominio cuando se cambia la URL de una página. Implementarlas correctamente garantiza que tanto usuarios como motores de búsqueda son dirigidos a la nueva ubicación del contenido sin perder valor SEO.

- Mantener el valor del enlace: Al usar redirecciones permanentes 301, se conserva la mayoría de la autoridad de la página original, lo que protege el posicionamiento obtenido en los motores de búsqueda.

- Actualización del sitemap: Tras realizar redirecciones, es clave mantener actualizado el mapa del sitio para reflejar las nuevas URLs, asegurando que los crawlers puedan encontrar y acceder al contenido fácilmente.

- Monitorear el tráfico: Es recomendable analizar el tráfico de las páginas redireccionadas para detectar posibles caídas en visitas o otros indicadores que puedan señalar problemas con la redirección.

Estrategias de contenido para mejorar la indexación

El contenido de calidad es fundamental para la indexación efectiva. Estrategias bien implementadas no solo mejoran la visibilidad en los motores de búsqueda, sino que también optimizan la experiencia del usuario. A continuación, se presentan diversas tácticas que pueden maximizar la indexación.

Creación de contenido de calidad

La calidad del contenido es esencial para atraer tanto a usuarios como a motores de búsqueda. Un buen contenido no solo satisface las necesidades de los usuarios, sino que también da a los motores de búsqueda razones para rastrear e indexar una página específica.

Intención de búsqueda del usuario

Comprender la intención detrás de las búsquedas es crucial. Utilizar herramientas de análisis y tendencias de búsqueda ayuda a identificar qué información buscan los usuarios. Esto incluye:

- Contenido informativo para búsquedas de tipo «qué» y «cómo».

- Ofertas y productos para consultas comerciales.

- Respuestas breves y concisas para preguntas directas.

Desarrollar contenido alineado con la intención de búsqueda aumenta la probabilidad de indexación y mejora la relevancia del sitio en los resultados.

Control de enlaces rotos

Los enlaces rotos pueden perjudicar la experiencia del usuario y afectar la indexación. Un sitio repleto de enlaces no funcionales puede enviar señales negativas a los motores de búsqueda, dificultando así la visibilidad. Es necesario realizar un control periódico para mantener la salud del sitio. Las recomendaciones incluyen:

- Utilizar herramientas de SEO para detectar enlaces rotos.

- Redirigir enlaces rotos hacia contenido relevante.

- Eliminar enlaces que lleven a páginas innecesarias o de mala calidad.

Gestión de códigos de estado HTTP

La correcta implementación de códigos de estado HTTP es crucial para la comunicación de la situación de las páginas web a los motores de búsqueda.

- Código 404: Indica que la página no se encuentra. Es importante personalizar esta página para mantener la experiencia del usuario.

- Código 301: Utilizado para redirecciones permanentes, permite transferir la autoridad de enlaces desde la URL antigua a la nueva.

- Código 503: Significa que el servidor está temporalmente fuera de servicio, útil para trabajos de mantenimiento programado.

Gestionar adecuadamente estos códigos ayuda a los motores de búsqueda a entender cómo interactuar con el contenido de un sitio, lo cual influye en su indexación.

Seguridad y SEO

La seguridad de un sitio web es un aspecto crucial para optimizar la indexación y la experiencia del usuario. Implementar medidas de seguridad adecuadas, como el uso de HTTPS, no solo protege la información, sino que también mejora el rendimiento en los motores de búsqueda

Importancia del HTTPS en la indexación

La adopción de HTTPS se ha vuelto un estándar necesario en la web moderna. Con la creciente preocupación por la privacidad y la seguridad en línea, los motores de búsqueda, especialmente Google, han comenzado a priorizar los sitios que implementan este protocolo seguro. El HTTPS cifra la información que se transmite entre el navegador del usuario y el servidor, protegiendo datos sensibles como contraseñas y números de tarjeta de crédito.

Los beneficios del uso de HTTPS en la indexación son claros y se detallan de la siguiente manera:

- Mejor clasificación en los resultados de búsqueda: Google ha confirmado que utilizar HTTPS es un factor de ranking. Esto significa que los sitios que aplican este protocolo tienen más posibilidades de aparecer en posiciones destacadas en los resultados de búsqueda.

- Aumento de la confianza del usuario: Los usuarios se sienten más seguros al navegar en sitios web que utilizan HTTPS, lo que puede aumentar la tasa de conversión y fomentar la lealtad a la marca.

- Protección contra ataques: El uso de HTTPS ayuda a mitigar ciertas amenazas, como ataques man-in-the-middle, lo que salvaguarda tanto al sitio web como a sus usuarios.

- Compatibilidad con modernas tecnologías web: Muchas aplicaciones y tecnologías web modernas requieren HTTPS para funcionar correctamente, lo que permite una mejor interacción y experiencia del usuario.

La implementación de HTTPS no sólo beneficia a la seguridad del sitio, sino que también es crucial para la visibilidad en los motores de búsqueda. Los propietarios de sitios que aún utilizan HTTP deben considerar la migración a HTTPS para cumplir con las expectativas actuales de seguridad y optimización.

Por último, es importante asegurar que todas las páginas redireccionen a sus versiones HTTPS. Esto garantiza que los motores de búsqueda indexen correctamente las páginas seguras y que los usuarios no se encuentren con errores al intentar acceder al contenido.

Control del contenido generado por usuarios

La moderación del contenido producido por los usuarios es esencial para evitar que se presenten elementos que puedan perjudicar la reputación de un sitio y su rendimiento en términos de SEO. Este proceso implica revisar y gestionar el tipo de contenido que se permite en la plataforma.

Para asegurar que el contenido sea de calidad, es recomendable implementar políticas claras que definan lo que se considera apropiado. Esto incluye:

- Definición de las pautas de contenido: Establecer unas normas claras que guíen a los usuarios sobre el tipo de contenido que pueden publicar. Estas pautas pueden abarcar desde el uso del lenguaje hasta la obligatoriedad de evitar el spam.

- Aplicación de filtros automáticos: Utilizar herramientas de moderación automatizadas que detecten lenguaje inapropiado o contenido spam. Esto ayuda a reducir el esfuerzo manual y a mantener el sitio limpio de contenido no deseado.

- Moderadores humanos: Complementar los filtros automáticos con la supervisión humana. La revisión manual permite tomar decisiones más matizadas y entender mejor el contexto de ciertos aportes, asegurando calidad en el contenido publicado.

Una revisión constante y la implementación de mecanismos eficaces de control potenciarán la credibilidad de la plataforma y ayudarán a fomentar un ambiente positivo para los usuarios.